1. はじめに:生成AIのハルシネーションに悩むあなたへ

「生成AIの回答は本当に信用できるのだろうか?」

ハルシネーションは生成AIを使い始めた多くの方が、一度は抱える疑問ではないでしょうか。

AIがもっともらしい文章で完璧に答えてくれたと思ったのに、後から調べたら全くのデタラメだった…。この「ハルシネーション」と呼ばれる現象は、私たちの作業効率を上げるどころか、かえって無駄なファクトチェックの手間を増やし、AIに対する不信感を募らせてしまいます。

でも、安心してください。ハルシネーションは、AIの「欠陥」ではなく「特性」として理解し、適切な付き合い方を身につければ、決して怖いものではありません。

この記事では、AIがなぜ嘘をつくのか、その根本原因から解説し、ハルシネーションを未然に防ぐ「3つの秘策」と、万が一発生した際の「対処法」を、具体的な事例を交えて徹底的に解説します。

この記事を読み終える頃には、あなたはもうハルシネーションに振り回されることなく、自信を持って生成AIを使いこなせるようになっているはずです。

2. まず知っておきたい「ハルシネーション」の基本

近年、ChatGPTなどの生成AIが私たちの生活に浸透しつつありますが、その便利さの裏側には、注意すべき重要な現象があります。それが「ハルシネーション(hallucination、幻覚)」です。AI初心者が生成AIを安全かつ効果的に使うために、このハルシネーションの基本をしっかり押さえておきましょう。

ハルシネーションって何? 😲

ハルシネーションとは、生成AIが事実に基づかない、誤った情報、あるいは完全にでっち上げの情報を、あたかも真実であるかのように自信満々に生成してしまう現象を指します。

人間が幻覚を見ることに例えられた言葉ですが、AIの場合、これは「嘘をついている」というよりも、学習したデータや統計的な処理の過程で、誤って最もらしい情報を作り出してしまう、一種の「勘違い」のようなものだと理解してください。

例えば、「太陽の主成分は水である」といった科学的に誤った情報を、出典や根拠があるかのようにスラスラと提示してくることがあります。また、存在しない人物や文献を引用したり、間違った計算結果を正しいと主張したりすることもあります。

なぜハルシネーションが起こるの? 🤔

生成AI、特に大規模言語モデル(LLM)は、大量のテキストデータを学習し、次に続く最も確率の高い単語を予測することで文章を生成します。この「最もらしい」単語を選ぶ過程で、事実よりも文脈の自然さや文章の構造を優先してしまう傾向があります。つまり、意味的に矛盾していても、文法的には正しい、「それっぽい」文章を作り出してしまうのです。

学習データに偏りや間違いがあったり、質問の意図が曖昧だったりする場合も、ハルシネーションのリスクが高まります。

どう付き合っていくべき? 💡

ハルシネーションは現在のAI技術が抱える避けられない課題の一つで、最も確実な対策は生成AIが出した情報を鵜呑みにしないことです。

特に、専門的な情報、統計データ、人名、事件、ニュースなどの正確性が求められる情報については、必ず別の信頼できる情報源(公式サイト、公的機関の発表など)で「ファクトチェック」を行いましょう。

また、2つの違った生成AI(例えばChatGPTとCopilot)で同じプロンプトで回答を比較してみることでもある程度のチェックはできるでしょう。回答が微妙に違っていたりなどは良く見うけられることです。おかしいなと感じたら更にファクトチェックを細かに行うことで確認するべきですね。

3. 【具体例】AIが「嘘」をついたハルシネーション事例

ハルシネーションは、知らず知らずのうちに私たちの仕事に悪影響を及ぼす可能性があります。ここでは、実際に報告されている代表的な事例を紹介します。

実例①:存在しない人物を「有名人」として紹介するケース

とある生成AIに「2010年代に活躍した日本の女性シンガー」について尋ねたところ、「高橋ユミ」という架空の人物を、ヒット曲や経歴まで詳細に創作して回答した事例があります。

この場合、AIは「日本の女性シンガー」や「2010年代」といったキーワードから、それらしい情報を組み合わせて、あたかも実在するかのような人物像を作り上げてしまいました。これは、あたかも辞書に載っているかのように見せかける「巧妙な嘘」であり、非常に見破りにくいケースと言えます。

実例②:根拠のないデータや数値を提示するケース

「日本のGDPの推移を教えて」と質問した際に、正確な情報ではなく、全く異なる数値を提示したり、存在しない統計データや機関名を引用するケースも報告されています。

AIは数字の羅列や専門用語を組み合わせるのが得意なため、一見すると信頼できる情報に見せかけることがあります。特にレポートや論文作成で数値を扱う際は、必ず一次情報(官公庁の発表など)に当たることが鉄則です。

実例③:架空の法律や専門用語を提示するケース

「〇〇県で自転車に乗る際の法律について教えて」という質問に対し、存在しない法律の名前や条文を提示した事例もあります。

AIは「法律の条文」のような形式的な文章構造を学習しているため、中身がデタラメでもそれらしい体裁で出力してしまいます。専門的な分野ほど、ハルシネーションは深刻な問題を引き起こす可能性があるため、注意が必要です。

実例④:教育現場を直撃!学生がハルシネーションを信じてレポート作成

実際にCNET Japanが報じた事例では、学生がChatGPTの生成した誤った情報を信じ込み、そのままレポートを提出して問題になるケースが多発している事を報じています。

レポート課題でAIに質問したところ、存在しない論文や著者を引用してしまったという事例や、史実に基づかない架空の出来事を書いてしまった事例などが報告されています。

これは、AIが生成した文章がどれほどもっともらしく見えても、最終的な情報の真偽は人間が確認しなければならない、という重要な教訓を示しています。

ピーマンの経験では1桁の計算(足し算だったかな?)を間違えていたこともあるし、音楽生成AIについての質問の回答として画像生成AIについての回答を堂々としてきたこともあります。笑

質問を投げかけた時のプロンプトが未熟(抽象的過ぎた?)だった影響もあるのでしょうが、出てきた回答には一通り目を通し、正誤を確認しなければならないことを痛感しました。

4. 【重要】ハルシネーションを回避する3つの秘策と対処法

ここからは、読者が最も求めている「ハルシネーションをどう防ぐか」に焦点を当て、明日からすぐに実践できる具体的な対策を解説します。

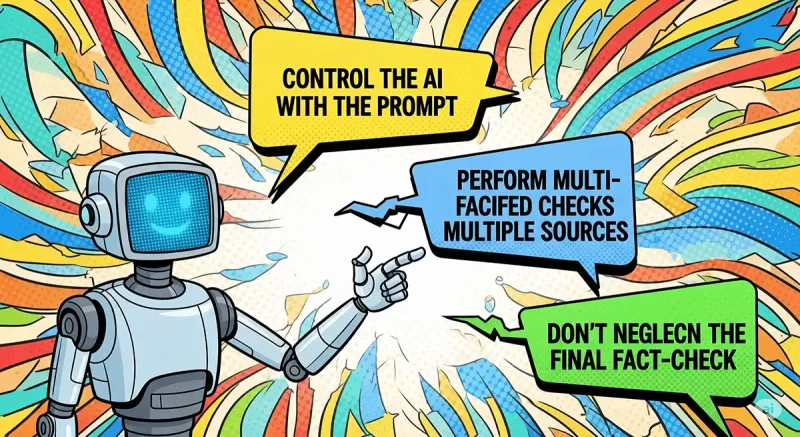

秘策1:プロンプトでAIを徹底的にコントロールする

AIは、ユーザーからの指示(プロンプト)次第で出力が大きく変わります。プロンプトを工夫することで、ハルシネーションの発生を大幅に抑えることができます。

役割を与える(役割プロンプト)

悪例:「自転車の法律を教えて」

改善例:「あなたは日本の法律に詳しい弁護士です。〇〇県で自転車に乗る際のルールを、根拠となる法律名とともに簡潔に教えてください。」

専門家としての役割と、根拠の提示を求めることで、AIはより正確な情報を探し出すようになります。

出力形式を強制する

悪例:「〇〇について教えて」

改善例:「〇〇について、以下の条件を守って回答してください。①箇条書きでまとめる、②出典となるURLを必ず3つ提示する、③架空の情報を書かない」

具体的なルールを設けることで、AIの自由な「創作」を厳しく制限できます。

情報源を指定する

例:「〇〇社の公式サイト(URLを記載)の内容だけを参考に、製品の特徴を3つ挙げてください」

AIが参照すべき情報源を限定することで、外部の不正確な情報を引き出すリスクをゼロに近づけられます。

秘策2:複数のツール・情報源で「多角的なチェック」を行う

一つの生成AIの回答だけを鵜呑みにするのは非常に危険です。常に複数の視点から情報を確認する習慣をつけましょう。

他の生成AIツールで再検証する

ChatGPTで得た回答を、Google GeminiやClaudeなどの別のAIツールでも同じプロンプトで質問してみます。

複数のAIが同じような回答を出せば、信頼性は高まります。

ウェブ検索でファクトチェックする

AIの回答に含まれる固有名詞(人名、会社名)、日付、数値などは、必ず通常のウェブ検索で裏付けを取りましょう。特に重要な情報であれば、信頼できるメディアや公的機関のウェブサイトに直接アクセスして確認する習慣が重要です。

秘策3:最終的なファクトチェックを怠らない

どんなにプロンプトを工夫しても、現在の生成AIではハルシネーションを完全にゼロにすることは難しいのが現状です。だからこそ、AIが出力した情報の「最終確認者」は常に自分であるという意識を持つことが非常に重要です。

ハルシネーションチェックの具体的な手順

- 固有名詞や数値は必ず検索:AIが出力した人名や企業の売上などは、必ず手動で検索し、存在するか、正しいかを確認します。

- 情報源が実在するか確認:AIが提示した参考文献やURLは、実際にアクセスして内容が一致するかを確かめます。

- 文脈の矛盾をチェック:文章全体を読み返し、不自然な言い回しや、論理の飛躍がないかを確認します。

この最後のチェックを習慣化することで、AIを「頼れるアシスタント」として活用しつつも、そのリスクをしっかり管理できる「AI使いのプロ」になることができます。

5. まとめ:ハルシネーションを恐れず、AIを使いこなすプロになるために

ハルシネーションは、生成AIを使う上で避けて通れない課題です。しかし、その原因と対策を正しく理解すれば、もう怖くはありません。

この記事でご紹介した「プロンプトの工夫」「多角的なチェック」「最終的なファクトチェック」を実践すれば、ハルシネーションのリスクを大幅に減らし、安心してAIを活用できます。

AIはあくまで強力なツールであり、その力を最大限に引き出すかどうかは、使い方次第です。ハルシネーションを適切に管理できることは、これからの時代、AIを使いこなせるプロフェッショナルになるための必須スキルです。ぜひ今日からこれらの対策を実践し、生成AIの可能性を最大限に引き出してください。

関連記事

- 【初心者必見】ChatGPTプロンプト例30選|成果倍増のコツも公開

- 【注意点】生成AIとどう付き合う?著作権・問題点・未来への視点

- 【超入門】生成AIとは?生成AIの種類・使い方・驚きの活用事例を徹底解説!

参考情報

- 内閣府:AIに関する暫定的な論点整理

「不正確な情報の生成(ハルシネーション)」という用語で、生成AIを利用する場合のリスクのトップに挙げられています。 - 総務省・経済産業省:AI事業者ガイドライン

ビジネスでAIを扱う際の「教科書」となる最新ガイドラインです。「情報の正確性」や「人間による確認」の必要性が詳しく述べられています。 - 文部科学省:学校における生成AI利用のガイドライン

最も分かりやすい言葉で「ハルシネーション」について触れているガイドラインです。第2章の「生成AIの性質」という項目で、ハルシネーションが図入りで解説されています(初心者向け解説の参考にもなります)。 - 消費者庁:一般消費者向け注意喚起

一般ユーザーが騙されないようにするための、最も「注意喚起」に近い文書です。「もっともらしい嘘をつく」という表現で、直接的なリスクとして警告されています。 - SIGNATE総研:ハルシネーションの対策5選!プロンプトも紹介

- SELF:【生成AI活用】ハルシネーションへの効果的な対策方法とは?

- 株式会社G-gen:AI 活用の落とし穴? AI ハルシネーションの原因・対策をわかりやすく解説!

コメント